AI推論重要性升 世芯、安國受惠

推論晶片對重複運算需求高,因此爲特定任務定製的ASIC晶片更受到業者青睞。圖/本報資料照片

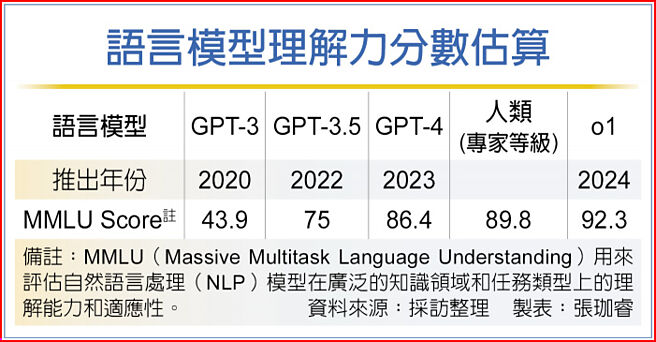

語言模型理解力分數估算

OpenAI針對大型語言模型一本正經說廢話痛點進行改善,o1模型透過多次確認產出之答案,增進語言模型商用之可能。業內人士解釋,現階段AI作爲客戶服務最大問題即是有小概率跳出錯誤答案或完全無關乎主題,o1模型會針對結果在三進行確認,這將使推論(Inference)算力需求增加。以AWS爲首之CSP業者針對推論應用推出自研晶片,法人認爲,推論重要性提升,將爲ASIC業者帶來新商機,其中如世芯-KY(3661)、安國(8054)有望受惠。

語言模型訓練所需算力高爲市場共識,並隨着參數增加、耗用成本提升,而推論基於預訓練模型進行結果產出,運算需求相對較低。不過OpenAI推出o1模型,開始推升推論對算力需求,其中,o1是首個IQ超過人類的AI模型,因此進行數學運算或邏輯推理,效果較好,另外就是改善一本正經講廢話或講錯誤答案的問題,商業實際應用空間擴大。

相關業者分析,過往推論相對簡單,但是o1透過將答案進行多次審覈,需要的算力有額外的提升。CSP業者如AWS、Meta針對推論需求都有推出自研晶片,如Inferentia 3、MTIA等。

有望推升臺廠商機,法人指出,推論晶片對重複運算需求高,因此爲特定任務定製的ASIC晶片更受到業者青睞,加上CSP建置量龐大,自研晶片分攤成本會較GPU划算,臺廠即接獲不少ASIC訂單,以世芯和AWS之合作最爲人所熟知。

法人分析,Inferentia 3的單位價值將高於Inferentia 2,不僅因爲製程從7nm 升級到3nm,且包括更多的運算晶片和HBM。供應鏈透露,世芯在後年爲Inferentia 3保留的產能超過目前水準,此外,AWS 的Trainium也可能採用Inferentia 3運算晶片,有望受惠市場份額的成長。

安國在第四季亦逐步開花結果,除原有的ASIC Turnkey外,CoWoS後段委託設計服務(Design Service)有望到手。法人認爲,儘管現階段客戶大部分來自大陸,但未來先進製程、封裝會以非大陸客戶爲主,大手筆購入Arm IP,進一步利用Arm生態系資源,擴大市場能見度。